交叉注意力

本文最后更新于:2024年10月20日 晚上

交叉注意力机制

1. 基本原理

在交叉注意力中,输入分为两个部分:

查询(Query):表示当前需要处理的信息,通常来自一个输入序列。

键(Key)和值(Value):表示需要参考的信息,通常来自另一个输入序列。

交叉注意力的计算过程如下:

相似度计算:对于每个查询向量,计算它与每个键向量的相似度(例如通过点积计算)。

权重归一化:将相似度通过 softmax 函数归一化,以得到各个键的注意力权重。

加权求和:用归一化的注意力权重对值向量进行加权求和,从而得到最终的输出。

这个过程使得查询可以从键值对中“提取”相关的信息,从而实现对输入序列之间的相互作用建模。

2. 交叉注意力的应用

交叉注意力在许多深度学习任务中有着广泛的应用,特别是在多模态数据处理、序列对序列(Seq2Seq)任务、以及生成模型中:

- 机器翻译:在 Transformer 模型中,交叉注意力用于编码器-解码器架构。解码器的查询是当前的翻译上下文,而键和值来自编码器输出,从而使解码器能够根据源语言的表示生成目标语言的翻译。

- 视觉-语言任务:在多模态模型中,交叉注意力可以用于将文本(语言描述)和图像(视觉特征)进行融合。例如,文本描述生成图像(图像生成)或根据图像回答问题(视觉问答)。

- 图像生成模型:如在 DALL-E 和 Stable Diffusion 等模型中,交叉注意力用于将文本描述转化为图像的生成条件。

3. 与自注意力的比较

- 自注意力(Self-Attention):查询、键和值都来自同一个输入序列,用于建模序列自身的内部依赖关系。

8 交叉注意力(Cross Attention):查询来自一个输入序列,而键和值来自另一个输入序列,用于建模不同序列之间的依赖关系和信息交互。

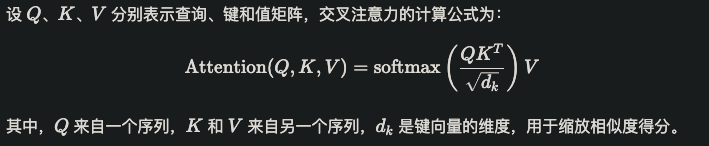

4. 数学表示

5. 优势和局限性

- 优势:能够灵活地对不同来源的信息进行关联,尤其在处理异质数据(例如文本和图像)时效果显著。

- 局限性:计算成本较高,尤其当两个输入序列都较长时,计算量会显著增加。

打赏支持

“如果你觉得我的文章不错,不妨鼓励我继续写作。”

交叉注意力

https://dreamoneyou.github.io/2024/交叉注意力/